Публикация 11 ноября 2025

Обновление 12 ноября 2025

Контроль индексации определяет видимость ресурса в Яндексе и Google. Разберем причины, по которым Google не индексирует некоторые страницы, и предложим решения для ускорения процесса индексации.

Процесс индексации сайта: что это и почему важно для видимости?

Индексация — добавление веб-страниц в базу поисковой системы после анализа. Это критический этап между публикацией и возможностью обнаружения пользователями. Задержки в индексировании страниц стоят бизнесу значительной доли потенциального трафика.

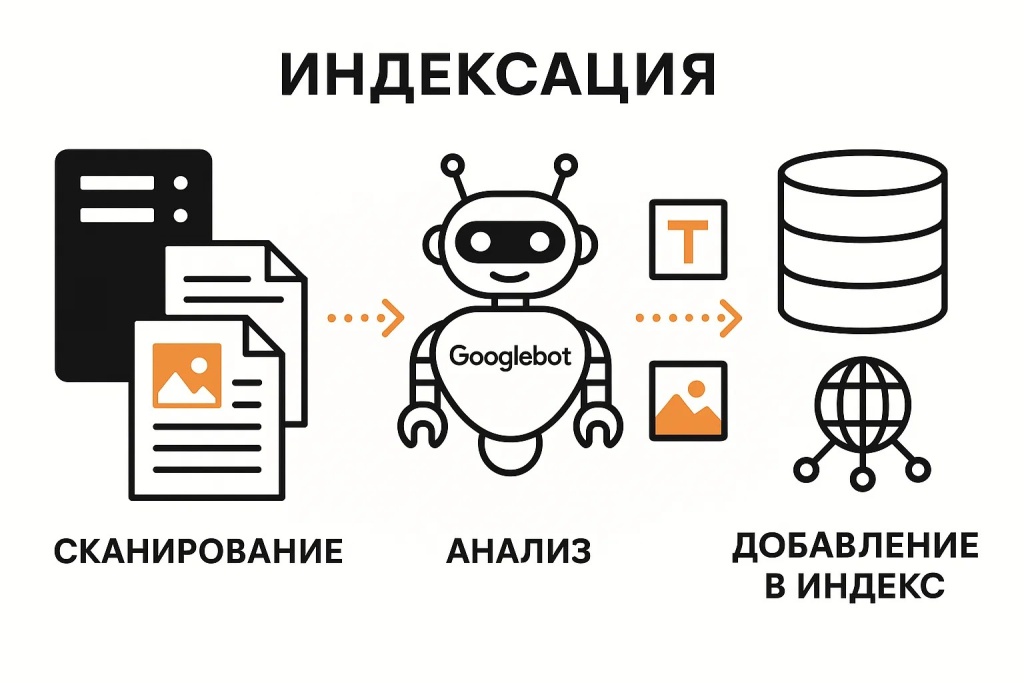

Как поисковая система индексирует ваш сайт: механизм работы

Процесс включает три этапа. Бот Googlebot обнаруживает URL через ссылки, карту сайта или внешние источники — это сканирование. Затем анализирует содержимое: текст, изображения, структуру, метаданные.

На финальном этапе обработанная информация сохраняется в индекс — базу для формирования результатов. Сканирование не гарантирует индексацию. Поисковая система может посетить страницу, но не добавить из-за низкого качества, дублирования или технических ограничений.

Скорость процесса зависит от авторитетности домена, частоты обновления и краулингового бюджета. Для новых проектов первичное индексирование занимает от нескольких дней до недель.

Почему без индексации страниц нет органического трафика?

Отсутствие страницы в индексе делает её невидимой, независимо от релевантности запросам. Даже идеально оптимизированный контент не принесет посетителей, если страница не находится в поиске Google.

Данные Search Console показывают, что проиндексированные страницы начинают получать показы в течение 24-48 часов после добавления. Задержка в индексировании ключевых разделов прямо влияет на упущенную выгоду — клиенты находят решения у конкурентов.

Регулярный мониторинг позволяет оперативно выявлять технические проблемы. Разница в несколько дней между появлением контента в индексе может определить лидера ниши.

Проверка индексации сайта: все эффективные способы

Выбор метода зависит от масштаба задачи и требуемой точности. Профессиональная проверка сайта предполагает использование нескольких инструментов.

Способ 1: Быстрая проверка индексации через оператор site:

Базовый оператор site: позволяет оценить наличие страницы в индексе за секунды. Для проверки всего ресурса ввести в строку поиска site:example.com — система покажет список страниц. Количество страниц отображается в верхней части выдачи.

Чтобы проверить индексацию конкретной страницы, используйте полный URL: site:example.com/category/article-name/. Если страница находится в индексе, увидите её с заголовком и описанием. Отсутствие результатов свидетельствует о проблемах.

Метод имеет ограничения. Гугл предоставляет приблизительное число, отличающееся от реальных данных на 10-30%. Использовать оператор site: для точной диагностики недостаточно — он не показывает причины исключения. Профессионалы комбинируют его с официальными инструментами.

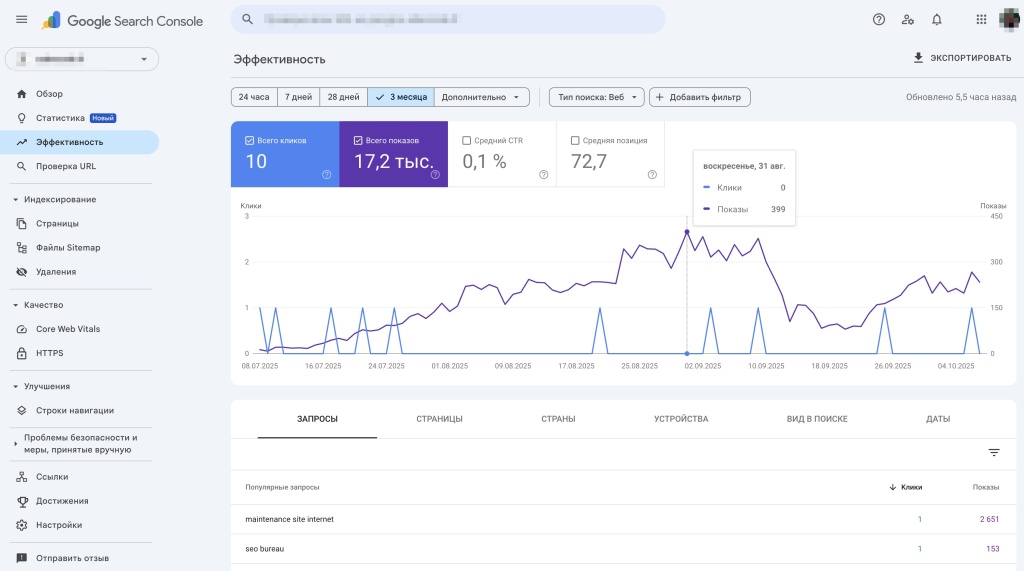

Способ 2: Проверка индексации конкретной страницы в Google Search Console

Search Console предоставляет достоверную информацию напрямую от системы. Инструмент "Проверка URL" позволяет получить детальный отчет о конкретной странице. Введите адрес, система покажет: проиндексирована ли страница, когда бот последний раз посещал, обнаружены ли ошибки.

Преимущество GSC — возможность запросить повторное сканирование после исправления проблем. Страницы, отправленные через консоль, обрабатываются в приоритетном порядке. Для коммерческих проектов это критический инструмент ежедневного мониторинга.

Способ 3: Проверка сайта через сторонние SEO-сервисы

Профессиональные SEO-платформы предлагают расширенную аналитику. Serpstat отслеживает динамику количества проиндексированных страниц в исторической перспективе, выявляя резкие изменения после обновлений.

Ahrefs Site Audit сканирует ресурс и сопоставляет обнаруженные страницы с данными о присутствии в базе. Инструмент показывает, какие страницы имеют низкий процент индексации, формирует отчет с приоритизацией проблем. Semrush Site Audit предлагает похожий функционал.

Ограничение сторонних сервисов — они опираются на собственные базы, а не на прямые данные от Google. Результаты могут отличаться от информации в Search Console на 5-15%. Платформы незаменимы для конкурентного анализа: оценка объема индексации чужих сайтов в поисковых системах.

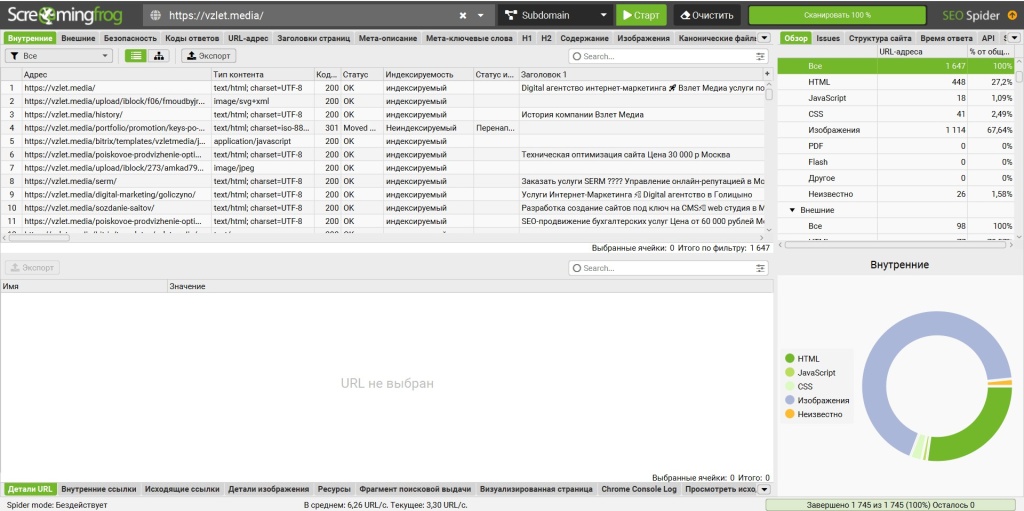

Способ 4: Массовая проверка индексации через программы сканирования

Screaming Frog SEO Spider — десктопное решение для комплексной диагностики. После сканирования программа проводит массовую проверку индексации через интеграцию с Google Search Console API. Результат — детальная таблица с отметками о присутствии каждой страницы.

Преимущество — возможность сопоставить статус с другими техническими параметрами в едином отчете. Вы видите, какие неиндексированные страницы имеют код ответа сервера 404, содержат noindex или закрыты в robots.txt. Это ускоряет диагностику на сайтах с тысячами страниц.

Альтернативные инструменты Netpeak Spider или Sitebulb предлагают схожий функционал.

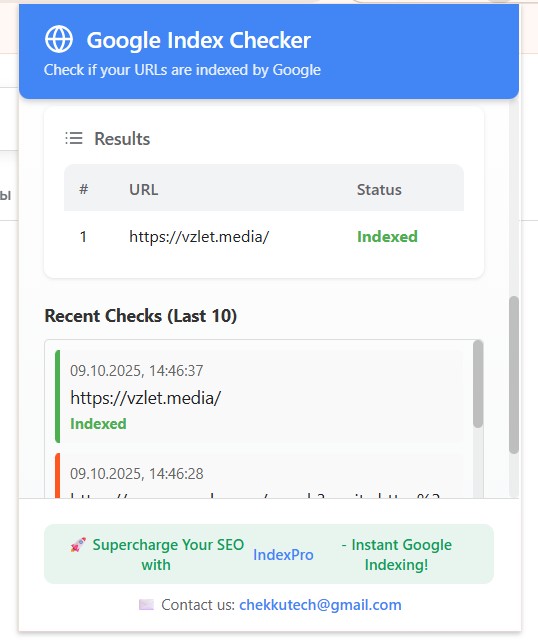

Способ 5: Экспресс-проверка индексации страницы через плагины браузера

Для оперативной проверки индексации страницы разработаны браузерные расширения. Расширение "Google Index Checker" для Chrome одним кликом показывает, проиндексирована ли открытая страница. Результат отображается иконкой — зеленая для проиндексированных URL, красная для отсутствующих.

SEOquake включает функцию быстрой проверки оператором site: из панели расширения. Инструмент показывает дату последнего кеша, что свидетельствует о частоте сканирования.

Букмарклеты — JavaScript-скрипты в закладках браузера — легковесная альтернатива. Один клик запускает проверку текущего URL. Решения подходят для ежедневной работы контент-менеджеров, которым нужен быстрый способ контроля публикаций.

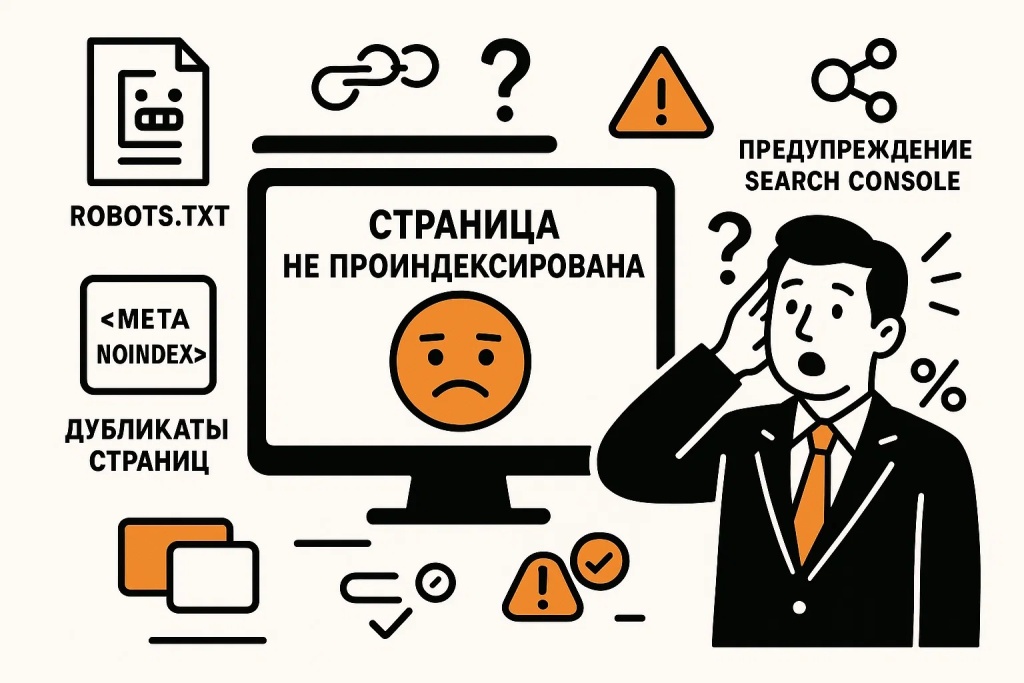

Почему Google не индексирует сайт: основные причины и решения

Исключение из индекса происходит из-за конкретных технических факторов или решений о качестве контента. Системный подход предполагает последовательную проверку распространенных блокировок.

Технические блокировки: когда Google не индексирует страницы

Технические ограничения составляют около 70% проблем, согласно статистике аудитов. Эти факторы контролируются владельцем и устраняются корректировкой настроек.

Проверка robots.txt: что блокирует процесс индексации

Файл robots.txt по адресу example.com/robots.txt содержит инструкции для поисковых роботов. Директива Disallow: /category/ запрещает индексацию страниц в указанном разделе. Частая ошибка — случайное добавление Disallow: / после миграции, блокирующее весь сайт.

Проверить содержимое можно через браузер или инструмент "Проверка robots.txt" в Google Search Console. Если обнаружена блокировка важных разделов, удалите строку Disallow или скорректируйте путь. После изменений Google необходимо время на повторное сканирование — от нескольких часов до суток.

Обратите внимание на директиву Crawl-delay, которую некоторые CMS добавляют автоматически. Хотя гугл её игнорирует, другие поисковые системы могут снизить частоту сканирования при высоких значениях.

Мета-тег noindex: скрытая причина, почему страница не индексируется

Мета-тег <meta name="robots" content="noindex"> в секции <head> явно указывает не добавлять страницу в индекс. Тег используется для служебных разделов, но может случайно остаться на публичных страницах после разработки.

Удаление тега требует редактирования шаблона или настроек CMS. После изменений запросите повторное сканирование через GSC. Гугл обрабатывает исправление в течение 1-3 дней для регулярно обновляемых сайтов.

Канонический тег: как он влияет на индексацию страниц

Канонический тег <link rel="canonical" href="https://example.com/other-page/"> сообщает, что текущая страница — дубликат, индексировать нужно указанный адрес. Неправильная настройка приводит к ситуации, когда важные страницы остаются вне индекса, передавая ценность дубликатам.

Решение — убедиться, что каждая уникальная страница не имеет canonical или canonical указывает на саму себя. Для дублированного контента canonical должен вести на основную версию. После исправления переиндексация занимает от нескольких дней до недели.

Проблемы с качеством: почему система не индексирует контент?

Поисковая система может не индексировать страницы, не соответствующие критериям качества, даже при отсутствии технических блокировок. Малоценный контент — тонкие страницы с текстом менее 300 слов, автоматически сгенерированные описания — часто игнорируются алгоритмами.

Дублированный контент представляет проблему для крупных сайтов. Если идентичный текст размещен на нескольких URL домена или скопирован с других ресурсов, гугл выбирает одну версию для индекса, исключая остальные. Инструмент проверки на плагиат и анализ внутренних дублей через Screaming Frog помогают выявить такие страницы.

Нарушение правил Google для вебмастеров влечет санкции вплоть до полного исключения сайта из индекса. К критическим нарушениям относятся клоакинг, скрытый текст, участие в схемах покупки ссылок, размещение вредоносного кода. Уведомления о ручных санкциях приходят в Search Console, алгоритмические фильтры работают без предупреждения.

Новый сайт: особенности процесса индексации

Молодые домены проходят период "песочницы" — задержку в полноценной индексации новых ресурсов. Поисковой системе требуется время для оценки авторитетности и качества. Первичное добавление происходит за несколько дней, но активное сканирование всех разделов откладывается на 2-4 недели.

Отсутствие внешних ссылок на новый сайт замедляет обнаружение роботами. Система выделяет ограниченный краулинговый бюджет доменам без репутации. В этот определенный период времени критически важно настроить XML-карту, оптимизировать скорость загрузки, публиковать качественный контент.

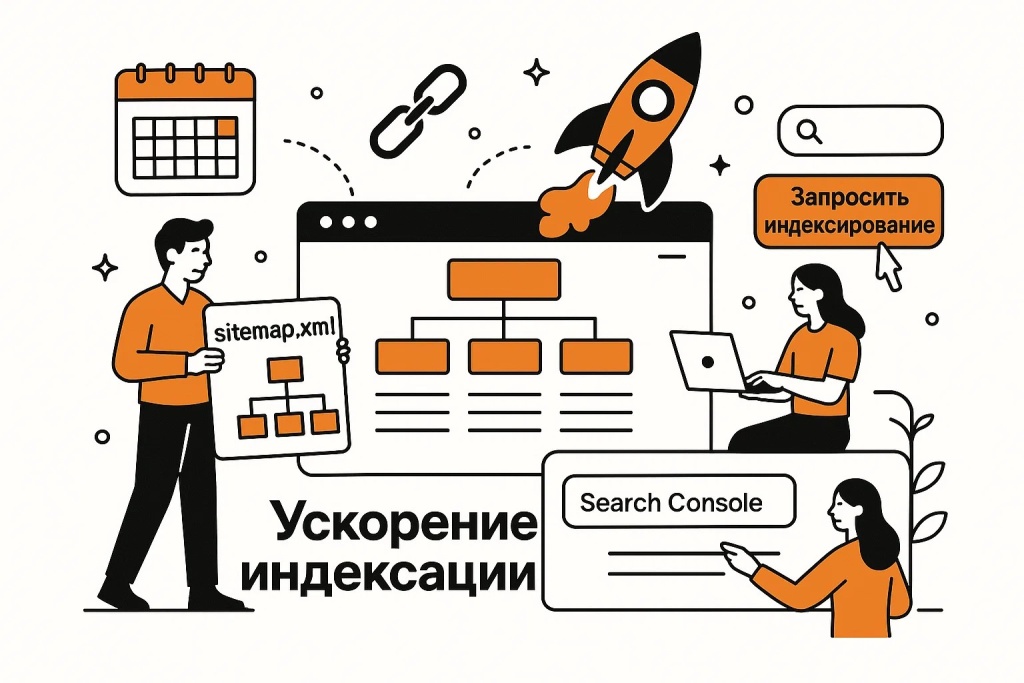

Как ускорить индексацию сайта в Google: проверенные методы

Активный подход к индексированию сокращает время между публикацией и началом получения трафика. Комбинация нескольких методов дает наилучший результат.

Ручной запрос: как ускорить индексацию конкретной страницы?

Инструмент "Проверка URL" позволяет отправить страницу на приоритетное сканирование. После ввода адреса нажмите "Запросить индексирование" — Google добавит URL в очередь. Страницы, отправленные этим методом, индексируются в среднем в 3 раза быстрее по сравнению с естественным обнаружением.

Sitemap.xml: ускорение индексации страниц через карту сайта

XML-карта представляет структурированный список URL, упрощающий обнаружение всех важных страниц. Файл должен содержать только канонические версии URL без дубликатов, параметров сессий, заблокированных страниц. Оптимальный размер — до 50 000 URL на одну карту.

Внутренняя перелинковка: как она ускоряет процесс индексации?

Логичная структура внутренних ссылок обеспечивает равномерное распределение краулингового бюджета. Страницы, до которых робот доходит за 3-4 клика от главной, индексируются быстрее и чаще пересканируются. "Сиротские" страницы без входящих ссылок могут оставаться незамеченными месяцами даже при наличии в sitemap.xml.

Создайте иерархическую структуру с четким разделением на категории. Размещайте ссылки на важные разделы в меню, футере, релевантных местах контента. Хлебные крошки улучшают навигацию и создают дополнительные пути для роботов.

Внешние ссылки: влияние на скорость индексации сайта

Ссылки с авторитетных ресурсов ускоряют обнаружение и индексацию контента. Когда бот сканирует внешний сайт и находит ссылку на ваш материал, он переходит по ней и добавляет URL в очередь. Качество источника влияет на приоритет — ссылка с новостного портала с высоким трафиком принесет быстрый эффект.

Естественное наращивание ссылочной массы происходит через создание контента, достойного упоминаний: оригинальные исследования, экспертные комментарии, инфографика. Активное участие в профессиональном комьюнити, гостевые публикации на тематических ресурсах формируют здоровый ссылочный профиль.

Избегайте массовых закупок некачественных ссылок — это может привести к санкциям и замедлению индексации. Один релиз на авторитетном отраслевом портале дает больший эффект, чем сотни ссылок с низкокачественных каталогов.

Indexing API: когда использовать для ускорения индексации?

Google Indexing API предназначен для оперативного уведомления о критически важных изменениях в узких нишах. Официально поддерживаются только вакансии (JobPosting) и стриминговые события (BroadcastEvent). Для этих типов API обеспечивает индексацию в течение нескольких часов или минут после отправки.

Использование API для других типов контента нарушает условия сервиса и может привести к блокировке. Для стандартных веб-страниц применяйте ручную отправку через Search Console или полагайтесь на естественное обнаружение через sitemap и ссылки.

Что важно запомнить?

Контроль индексации сайта в поисковых системах составляет основу эффективной SEO-стратегии. Регулярная проверка через Google Search Console выявляет проблемы на ранних стадиях. Комбинация оператора site: для быстрой оценки и детальных отчетов GSC обеспечивает полный контроль над видимостью сайта в поисковых системах.

Большинство проблем имеют техническую природу и решаются корректировкой настроек: проверьте robots.txt, мета-теги noindex, канонические ссылки. Качественный контент, логичная перелинковка, корректно настроенная XML-карта создают оптимальные условия для работы поисковых роботов.

Часто задаваемые вопросы

Сколько времени занимает процесс индексации новой страницы?

В чем разница между сканированием и процессом индексации?

Что такое краулинговый бюджет и как он влияет на индексацию страниц?

Краулинговый бюджет — условный термин для обозначения ресурсов, выделяемых на сканирование конкретного сайта за определенный период времени. Поисковая система балансирует между желанием обнаружить все изменения и необходимостью эффективно распределять вычислительные мощности между миллионами доменов. Для небольших сайтов до 1000 страниц краулинговый бюджет редко становится ограничивающим фактором — Google успевает регулярно сканировать весь контент.

Крупные порталы с десятками или сотнями тысяч страниц сталкиваются с ситуацией, когда робот не успевает обрабатывать изменения.

На размер краулингового бюджета влияют авторитетность домена, скорость загрузки, частота обновления контента, количество ошибок сервера.