Публикация 26 марта 2025

Обновление 5 сентября 2025

Черное SEO (или Black Hat SEO) — это совокупность запрещённых методов оптимизации сайта, направленных на искусственное повышение позиций в поисковой выдаче. Такие подходы нарушают рекомендации поисковых систем и ориентированы не на пользователя, а на манипуляцию алгоритмами ранжирования. Основной акцент делается на краткосрочный результат: резкий рост трафика, быстрый выход в топ. Однако за этим нередко следуют фильтры, санкции и полное исключение из индекса.

В отличие от «белого» SEO, где упор делается на улучшение качества контента, юзабилити и технической оптимизации, чёрные практики подменяют ценность обманом. Сложность заключается в том, что часть этих техник может оставаться незамеченной до обновления алгоритма, после чего последствия становятся необратимыми.

Основные Методы Черного SEO

Применение манипулятивных стратегий часто базируется на эксплуатации технических уязвимостей и алгоритмических особенностей поисковиков. Ниже представлены ключевые приёмы, активно использовавшиеся или используемые до сих пор.

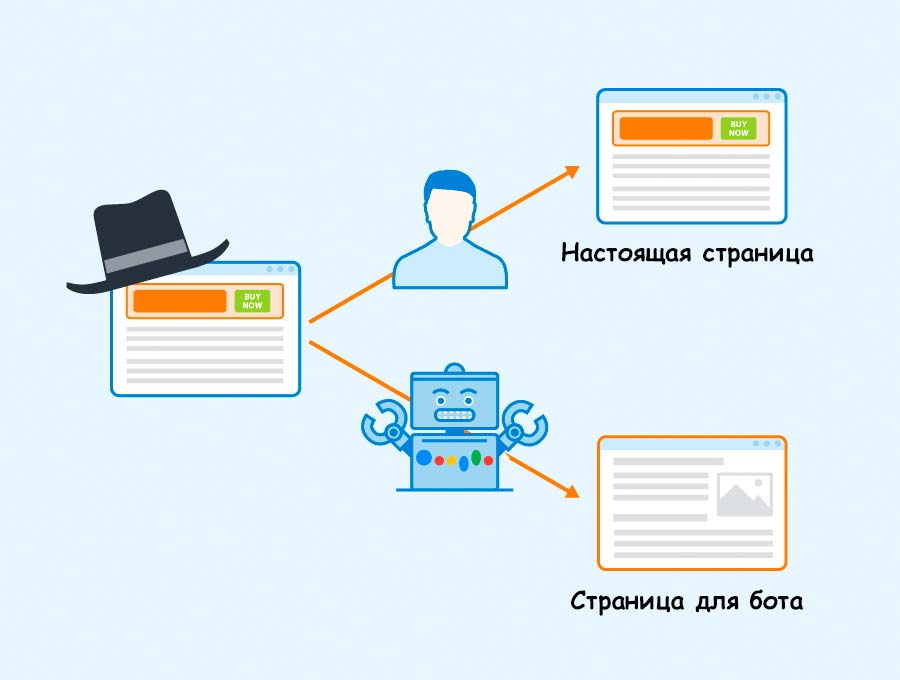

Клоакинг — разные версии страницы для роботов и пользователей

Клоакинг предполагает предоставление разных версий одной и той же страницы в зависимости от типа посетителя. Поисковому боту отдается одна версия — с высокой плотностью ключей, скрытыми элементами и SEO-текстами. Пользователь же видит визуально чистый, но иной по содержанию контент.

Пример клоакинга в черном SEO: что видит бот и пользователь

Такая технология реализуется через проверку user-agent или IP-адреса. Например, ботам Google демонстрируется HTML-страница с переоптимизированным содержанием, тогда как обычные посетители видят лендинг без текстовой части. Поисковые системы рассматривают это как обман алгоритма индексации и при обнаружении применяют санкции вплоть до полного исключения из SERP (поисковой выдачи).

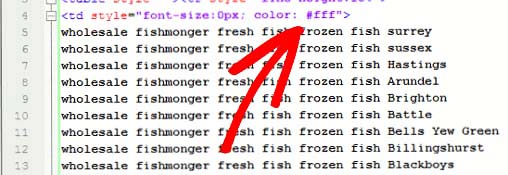

Скрытый текст — невидимое наполнение страницы

Размещение текста вне видимой зоны — один из старейших методов манипуляции. Используются стили CSS (display:none, visibility:hidden) или совпадение цвета шрифта с фоном. Иногда текст выводится за пределы экрана через отрицательные значения margin.

Пример скрытого текста в коде сайта.

Основная задача — увеличить релевантность страницы по ряду запросов, не перегружая визуальную часть. Однако современные поисковые алгоритмы легко распознают такие блоки и интерпретируют их как нарушение рекомендаций.

Переоптимизация — чрезмерная плотность ключевых слов

Слишком высокая концентрация ключевых фраз в тексте ухудшает читабельность и воспринимается как попытка манипулировать релевантностью. Такой подход был эффективен до появления алгоритмов вроде Google Panda, ориентированных на качество контента.

Аналитика показывает, что тексты с ключевой плотностью свыше 3–4% значительно чаще попадают под фильтры. Кроме того, переоптимизированный сайт может потерять доверие у пользователей, особенно если фразы встроены неестественным образом.

Дорвеи — страницы без пользы, но с трафиком

Дорвеи (doorway pages) — это страницы, созданные исключительно под конкретные поисковые запросы, не несущие ценности. Они оптимизируются под узкие кластеры ключей и перенаправляют трафик на основной ресурс. Структура таких страниц максимально упрощена, а тексты либо автоматически сгенерированы, либо состоят из синонимического набора слов.

Поисковики научились распознавать дорвеи по шаблонному контенту, отсутствию уникального пользовательского опыта и избыточному количеству редиректов.

Ссылочные фермы — искусственное наращивание ссылочной массы

Ссылочные фермы — это сайты, созданные для размещения большого числа исходящих ссылок с целью поднятия ссылочного профиля других ресурсов. Часто используется автоматизированное ПО или сети взаимного обмена ссылками.

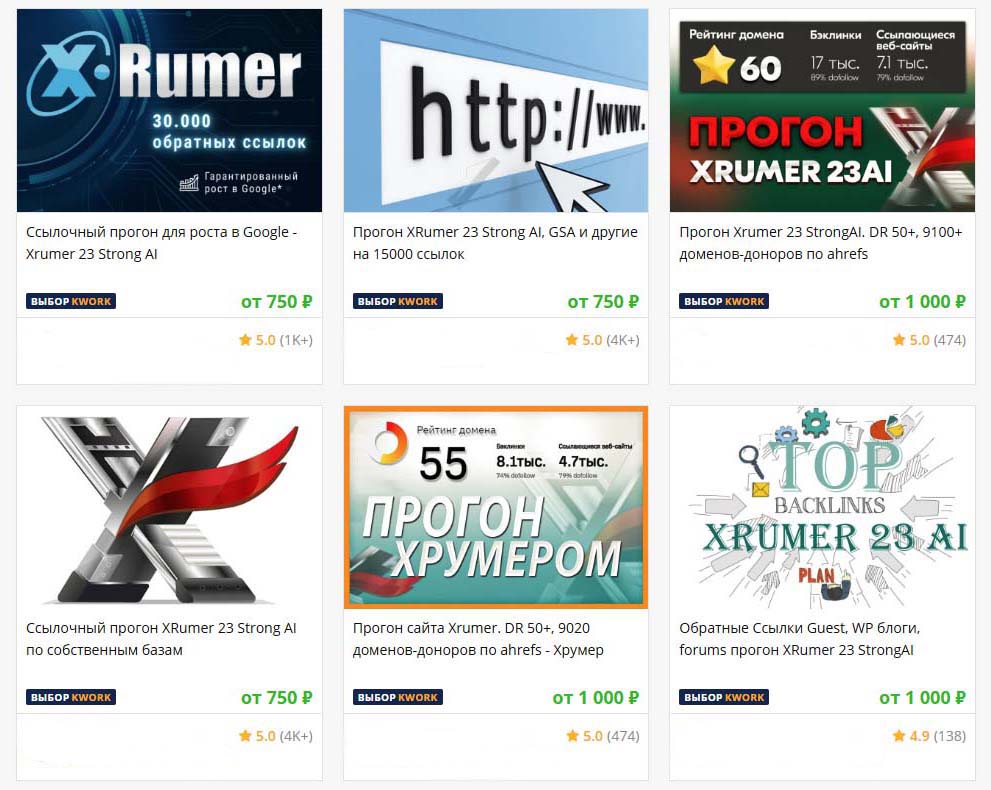

Автоматизированный прогоны ссылок через XRumer — инструмент Черного SEO.

Популярные инструменты для черного линкбилдинга:

-

XRumer — автоматизированная система для массового размещения ссылок на форумах, блогах и комментариях. Часто используется для создания спам-ссылок.

-

GSA Search Engine Ranker — программа для генерации ссылочной массы на тысячи сайтов. Работает без постоянного вмешательства, может обходить капчу.

-

Сеть сателлитов — группа сайтов, созданных исключительно для передачи ссылочного веса. Маскируется под реальную сетку, но выявляется алгоритмами Penguin.

Несмотря на маскировку, современные алгоритмы (в частности, Google Penguin) умеют отличать естественные ссылки от искусственно размещённых.

Накрутка поведенческих факторов — имитация действий пользователей

Для поисковых систем поведенческие метрики — один из сигналов релевантности. Поэтому недобросовестные оптимизаторы имитируют поведение реальных пользователей: запускают массовые переходы по запросам, увеличивают среднее время на странице, имитируют взаимодействие с интерфейсом.

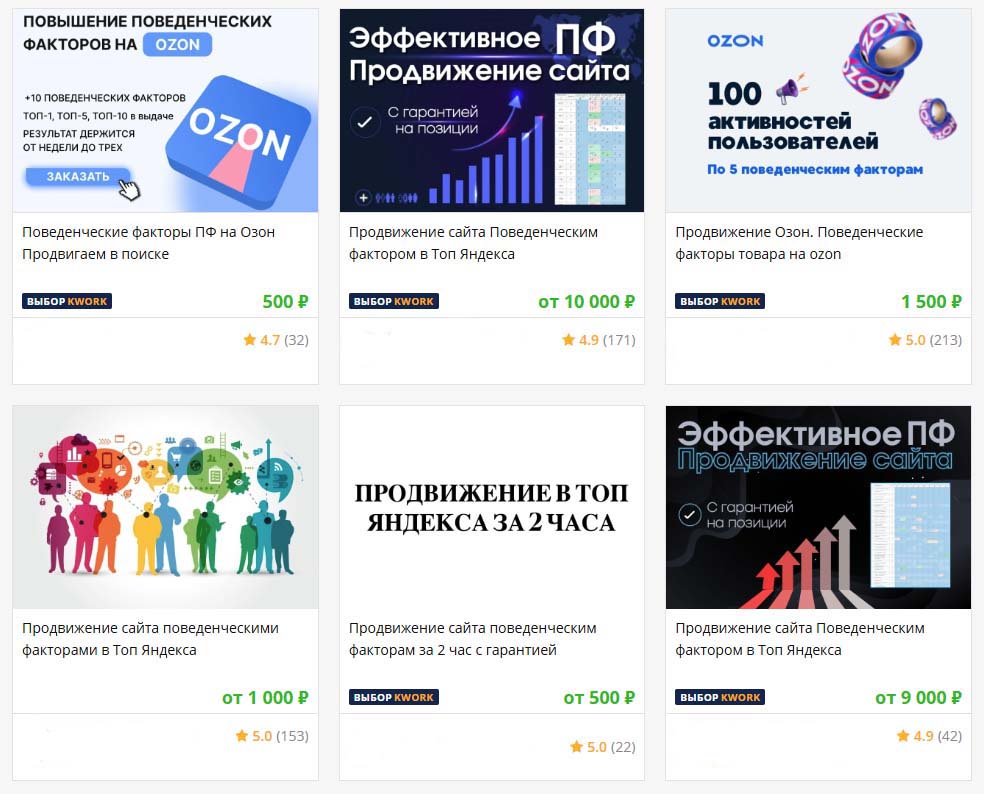

Накрутка поведенческих факторов — примеры с бирж фрилансеров.

Реализация происходит через ботнеты, прокси-серверы и даже крауд-платформы. Но рост CTR при низком вовлечении или неестественная повторяемость паттернов может сигнализировать алгоритмам о вмешательстве и привести к штрафам.

Контентный скрапинг — заимствование чужих материалов

Скрапинг — автоматическое копирование текстов и медиафайлов с других сайтов для наполнения собственного ресурса. Часто применяется для быстрого запуска сателлитов или дорвеев. Используются парсеры, краулеры и скрипты на Python.

Основные риски:

-

попадание под фильтры за дублирование контента;

-

жалобы по DMCA;

-

невозможность ранжироваться выше оригинала;

-

снижение индекса доверия со стороны поисковиков.

Юридически это может классифицироваться как нарушение авторских прав, особенно в юрисдикциях с активным соблюдением законов о контенте.

Риски и Последствия Черного SEO

Использование запрещённых методов оптимизации неизбежно приводит к санкциям со стороны поисковых систем. Падение позиций, снижение доверия, полное исключение сайта из индекса — лишь часть возможных последствий. Даже кратковременный успех оборачивается долгосрочными убытками и репутационными потерями.

Санкции могут быть как автоматическими, так и ручными, что усложняет процесс диагностики и восстановления. Особенно уязвимы коммерческие сайты, для которых органический трафик — ключевой источник привлечения клиентов.

Наложение фильтров — временные и постоянные санкции

Поисковые системы применяют алгоритмические и ручные меры при выявлении попыток манипуляции.

Фильтры поисковых систем:

-

Google Penguin — анализирует ссылочный профиль, выявляет неестественные или покупные ссылки.

-

Google SpamBrain — алгоритм на базе ИИ, распознаёт спам, мошеннические и манипулятивные сайты.

-

Яндекс АГС — наказывает за массовое размещение низкокачественных страниц без полезного контента.

-

Яндекс Минусинск — снижает позиции сайтов с подозрительным или чрезмерно наращённым ссылочным профилем.

Фильтр может действовать временно, пока не устранены нарушения, либо постоянно, если сайт признан систематическим нарушителем. В некоторых случаях восстановление занимает месяцы и требует полного пересмотра стратегии.

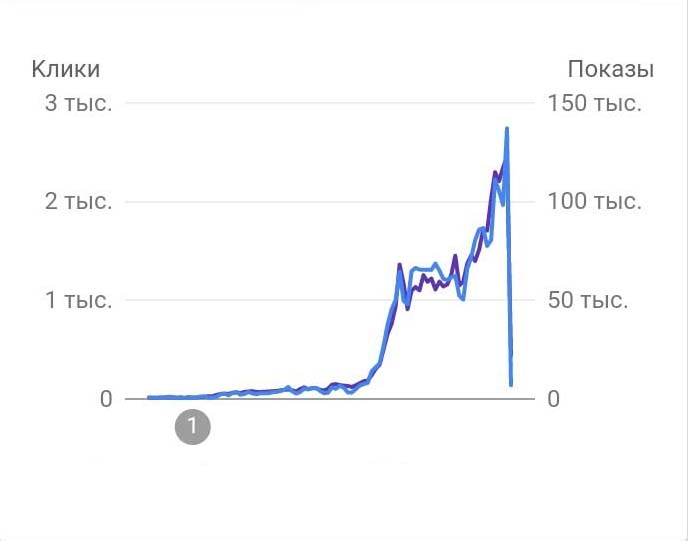

Падение позиций — потеря органического трафика

Резкое снижение видимости в выдаче часто происходит без предварительных уведомлений. Отчёты в Google Search Console или Яндекс.Вебмастере могут сигнализировать о снижении индексации, увеличении количества страниц с ошибками или потере ссылок.

Резкое падение трафика после санкций Google за черное SEO.

Причины варьируются: переоптимизация контента, неестественные анкоры, чрезмерное дублирование. Вернуть утраченные позиции сложно — алгоритмы учитывают историю домена, и даже после исправления доверие может быть утрачено.

Исключение из индекса — бан поисковыми системами

Полное удаление сайта из поисковой базы означает нулевой органический трафик. Такая мера применяется за систематическое использование запрещённых техник — массовое размещение дорвеев, скрапинг, клоакинг и накрутку поведенческих сигналов.

Проверить факт бана можно вручную, введя в поиск команду site:имя_сайта. Отсутствие результатов — признак исключения. Восстановление возможно только после подачи апелляции и устранения всех выявленных нарушений.

Почему применяют черное SEO?

Несмотря на высокий риск, недобросовестные подходы сохраняют популярность в отдельных сегментах. Причина — стремление к быстрому результату при ограниченных ресурсах или жёсткой конкуренции.

Для краткосрочных проектов с ограниченным жизненным циклом такие методы могут показаться оправданными, особенно если задача — быстро выйти в топ под нишевую выдачу.

Быстрый рост и временное преимущество

Некоторые владельцы сайтов сознательно игнорируют долгосрочные риски, выбирая путь агрессивной экспансии. Кратковременный успех выражается в росте позиций, увеличении трафика и конверсий.

Однако наша аналитика показывает: уже через 3–6 месяцев такие проекты теряют до 80% видимости, а восстановление, если оно возможно, требует значительно больших инвестиций. Это может свидетельствовать о неэффективности краткосрочных тактик в условиях усиливающейся модерации поисковых систем.

Белое, серое и черное SEO

Подход к поисковой оптимизации можно условно разделить на три уровня: этически чистый, допустимый с оговорками и запрещённый. Каждый из них характеризуется разной степенью устойчивости, прозрачности и соответствием рекомендациям поисковых систем.

В таблице ниже представлены ключевые различия:

|

Подход |

Методы |

Риски |

Долговечность |

|---|---|---|---|

|

Белое SEO |

Уникальный контент, UX, внутренняя оптимизация |

Минимальные |

Высокая |

|

Серое SEO |

Сетевые ссылки, частичный клоакинг, агрегация |

Умеренные |

Средняя |

|

Черное SEO |

Скрапинг, дорвеи, клоакинг, саттелиты |

Максимальные |

Низкая |

Белое SEO — безопасное продвижение с долгосрочным эффектом

В этой модели основное внимание уделяется качеству контента, скорости загрузки, адаптивности, технической чистоте и полезности страницы. Практики включают:

-

создание экспертных материалов;

-

улучшение структуры сайта;

-

оптимизацию под E-E-A-T;

-

получение естественных ссылок.

Такие сайты устойчивы к обновлениям алгоритмов и способны занимать высокие позиции в течение нескольких лет.

Серое SEO — методы на грани допустимого

Методология находится между допустимыми и запрещёнными действиями. К примеру, закупка ссылок без явной автоматизации, размещение оптимизированного контента на сторонних ресурсах без указания рекламы, использование микросетей.

Механизмы часто не фиксируются сразу, но могут быть выявлены вручную. Баланс между выгодой и риском достигается за счёт минимизации экспозиции — ссылки размещаются дозированно, контент адаптируется под пользовательские сценарии.

Черное SEO — агрессивное нарушение правил

Чёткое отличие — целенаправленное игнорирование политик поисковых систем. Используются автоматические генераторы, дорвеи, PBN, редиректы по геолокации, а также скрипты для имитации активности.

Типовые ошибки включают:

-

массовую закупку низкокачественных ссылок;

-

копирование чужого контента;

-

неестественную структуру URL и мета-тегов.

Каждое из этих действий резко снижает шанс на восстановление позиций после санкций. В условиях регулярных апдейтов и роста конкуренции такие схемы теряют эффективность.

Актуальность черного SEO

Несмотря на развитие алгоритмов, методы черного SEO всё ещё применяются в определённых сегментах рынка. Особенно часто они встречаются в нишах с высокой конкуренцией, ограниченным сроком жизни продукта или отсутствием регулирования.

Сценарии использования черного SEO:

-

Продвижение одностраничных сайтов под быстрые продажи.

-

Маркетинг финансовых офферов с агрессивной монетизацией.

-

Оптимизация анонимных и серых сервисов.

-

Работа с зарубежным трафиком, особенно в странах с низкой модерацией.

-

Временные проекты с ограниченным жизненным циклом.

Отдельные подрядчики на аутсорсинге продолжают использовать скрытые схемы, обещая гарантированный рост позиций, игнорируя последствия после завершения контракта. Это создаёт риск не только для новых проектов, но и для действующих брендов, делегирующих продвижение сторонним исполнителям без достаточного контроля.

Тренды и адаптация под новые алгоритмы

Чёрные методы трансформируются в ответ на ужесточение алгоритмов. Прямой клоакинг заменяется подменой через JavaScript или динамическим контентом по сессиям. Ссылочные схемы переходят в закрытые сети, маскируются под крауд или условно натуральные обзоры.

Алгоритмы машинного обучения усложняют задачу, но злоупотребления становятся всё более изощрёнными. В ряде случаев автоматическое выявление нарушений затруднено, особенно если применяется рандомизация и разбивка активности по времени. Однако точечные апдейты, такие как Google Spam Update, демонстрируют растущую точность алгоритмических фильтров.